Tình hình giá cả cổ phiếu của AMD và NVIDIA sau cú deal long trời lỡ đất giữa OpenAI và AMD

https://openai.com/index/openai-amd-strategic-partnership/

OpenAI sẽ xây dựng một cơ sở sản xuất dựa trên dòng chip MI450 của AMD sắp ra mắt. Các giám đốc điều hành của AMD kỳ vọng thỏa thuận với OpenAI sẽ mang lại hàng chục tỉ USD doanh thu mỗi năm.

Loại GPU mới của AMD là MI450 sẽ cùng OpenAI thiết kế phát triển, năng suất hiệu quả của nó sẽ được tính theo giá trị điện năng tiêu thụ ROI. Nếu AMD có thể sản xuất GPU với chi phí thấp hơn (thiết kế hiệu quả, chi phí wafer rẻ hơn, chi phí bản quyền / ecosystem thấp hơn) thì OpenAI có thể tiết kiệm rất nhiều khi triển khai hàng gigawatt. Nếu hiệu năng / watt tương đương hoặc hơi thấp hơn, nhưng chi phí thấp hơn nhiều, thì vẫn có thể hấp dẫn.

Tiêu Thụ Điện Năng Cơ Bản

Đã nói về AI tính toán thì nói về điện năng tiêu thụ, hiện tại nếu dùng GPU để training, inferer/tính toán, như sử dụng ComfyUI trên máy tính đơn, thì mỗi hệ thống đơn lẻ với 1 GPU chơi game như RTX4090, 5090 có thể lên hơn 1000W ~1kW chạy hết công suất. 6 Gigawatt trên của OpenAII cung cấp là tương đương với công suất điện của một tỉnh thành đâu đó ở Việt Nam, không phải khu vực trung ương hoặc toàn bộ đất nước Singapore hiện nay.

Một máy tính đơn đang sử dụng tại Việt Nam với cấu hình như nêu thì sẽ tốn trung bình 2.6tr/ngày ~ 3.4tr/ngày nếu áp dụng khung giá điện của Việt Nam, mức tiêu thụ có thể lên đến 1.3kW/ngày.

Lấy ví dụ: 1 studios VFX & Animation hay một cty có sử dụng AI cho việc tính toán ở Việt Nam với cluster farm đơn thuần kết nối đa GPU x 100 đơn vị, sẽ tiêu tốn ước tính 3.1tỷ VnĐ/năm hoặc 260 triệu đồng VNĐ /tháng chỉ riêng tiền điện.

Cái này mà thêm hệ thống làm mát thì chắc phải lên Tây Bắc, ngồi trong rừng tre hay Tả Chí Nhù, Bạch Mộc Lương Tử rồi mở cty để nó lạnh bớt phần nào cho.

Chi phí biểu giá điện năng được tính theo chi phí Bộ Công Thương đưa ra vào 2025. https://www.evn.com.vn/d/vi-VN/news/Bieu-gia-ban-le-dien-theo-Quyet-dinh-so-1279QD-BCT-ngay-0952025-cua-Bo-Cong-Thuong-60-28-502668

Vì sao phải GPU AI chứ không phải GPU chơi game ?

- GPU AI hiện tại có thể tính được các phép tính về ma trận lớn (tensor ops) FP8/FP16 (floating point standard) vô cùng chính xác, sử dụng riêng HBM3/4 (high bandwidth memory chứ không phải ram GDDR), cho băng thông lên tới TB/s.

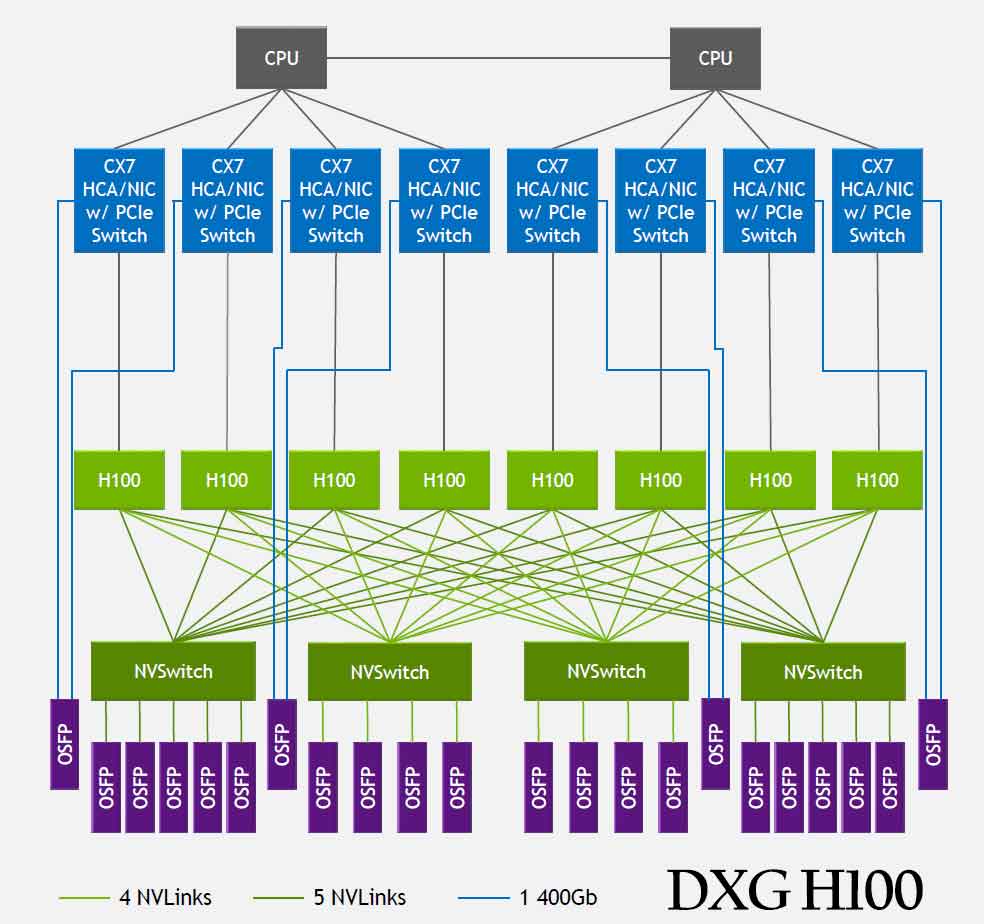

- Có thể dùng các kiểu kết nối nhiều GPU vào trong một mạng cluster, thông qua công nghệ của hãng NvLInk của Nvidia, Infinity Fabric của AMD

- Bản thân GPU AI có tensor core, matrix core, cái này card chơi game không có, có thể chạy các framework dành riêng cho AI ở cấp phần cứng (PyTorch, ROCm, CUDA, NCCL, MPI)

Riêng việc không sử dụng PCIe rất chậm, 32 GB/s), Infinity Fabric/NVLink tạo ra mạng riêng (mesh / ring / torus topology) cho phép các GPU truyền tensor, gradient, và activation trực tiếp với độ trễ cực thấp.

Về network khi sử dụng GPU của AMD thay vì Nvidia:

Nếu AMD làm tốt thiết kế mạng nội bộ giữa GPU (via fabric, Infinity Fabric, Ethernet) để giảm chi phí dây, cáp, chuyển mạch, đặc biệt trong các hệ thống cực lớn, thì có thể có lợi thế so với thiết kế đắt đỏ của Nvidia dùng cáp quang, switch chuyên dụng, etc. Ví dụ, AMD đề xuất sử dụng (copper passive) dây đồng thay vì quang để giảm chi phí trong hệ IF128.

Nvidia có hệ sinh thái CUDA rất mạnh, và nhiều hãng AI “bị lock-in” vào CUDA. AMD nếu có giải pháp phần mềm mở (ví dụ ROCm) mà dễ dùng, dễ tương thích, có thể thu hút được những AI công ty mong muốn tránh lệ thuộc Nvidia. (Đã có thông tin AMD đang hợp tác với startup AI để đẩy ROCm, thu thập ý kiến để cải thiện phần mềm)

Vì sao không dùng CPU thay GPU được hoặc ngược lại

GPU ko thể quản lý được hệ thống, cấp logic tuần tự, tính toán nhánh (ví dụ thiết bị A chạy xong tới thiết bị B rồi toàn bộ hệ thống mỗi thiết bị được scheduler chạy thế nào dựa trên hệ điều hành chỉ định). Ngoài ra GPU cũng không làm được như CPU batch loading, giao tiếp mạng, lưu trữ, đọc ghi dữ liệu … nôm na CPU là làm tốt công việc nhà quản trị, cấp phát nguồn lực

Thế mạnh của GPU là tính toán song song, như những bộ máy riêng lẽ có thể làm 1 chuyện đồng thời vô cùng tốt, giải quyết được hàng triệu phép nhân cộng trong ma trận rốp rẻng

CPU sẽ vẫn đóng vai trò trung tâm, chỉ huy job giao xuống và GPU sẽ gánh tải các job (gradient, huấn luyện tensor, nén và gửi gradient) đó, tính toán ra kết quả.

Tiêu Thụ Điện Năng Cao Cấp

- Tổng công suất thủy điện Sơn La hiện nay là 2.4 GW (2400 mega watt)

- Thủy điện Hòa Bình 1.9GW

- Nhiệt điện Phả Lại 3.9GW

- Cả cái Singapore ~6 GW

- cụm hạ tầng GPU mà OpenAI ký kết với AMD ≈ bằng tổng công suất điện của Singapore hoặc 3 nhà máy thủy điện Sơn La gộp lại.

6 gigawatt của OpenAI công bố = 6.000 megawatt = 6 tỷ watt điện. Tức khoảng 5–7,5 triệu GPU AI chuyên dụng hoạt động cùng lúc. Gấp 3–4 lần toàn bộ số GPU mà Microsoft Azure + Google Cloud + Amazon + Meta đang có gộp lại (2025).

Tương đương tổng số GPU AI của cả hành tinh hiện tại, gom về một chỗ.

Mở Rộng Vấn Đề Tiêu Thụ Điện Năng

Ước tính: với cấu hình hạ tầng hiện tại, FPT AI Cloud, VinAI và Zalo AI là ba đơn vị đang vận hành các cụm tính toán AI lớn nhất Việt Nam. Nếu giả định hệ thống hoạt động 16 tiếng/ngày ở công suất tối đa, theo khung giá điện kinh doanh giờ cao điểm (5.422 đồng/kWh), chi phí vận hành có thể được ước tính như sau:

FPT

Theo công bố tháng 4/2025 của FPT: FPT đầu tư cụm AI Data Center 2000 GPU H100 / H200, tổng công suất khoảng 1–1.2 MW.

Đây là mức trung bình của một trung tâm dữ liệu AI khu vực, tương đương 0.0002 GW, tức chỉ bằng 0.003 % cụm 6 GW của OpenAI. FPT tuyên bố “đã khai thác hết công suất” thực ra nghĩa là: họ đã dùng toàn bộ số GPU hiện có cho khách hàng doanh nghiệp, dịch vụ AI, LLM tiếng Việt (FPT.AI LLM, aka.ai, v.v.), chứ không phải là họ đã chạm tới giới hạn vật lý kiểu OpenAI scale. So với cái deal của OpenAI và AMD thì quy mô FPT mới bằng 1/5000.

Tiêu thụ khoảng 1.2 MW điện, tương đương ~3.1 tỷ đồng/tháng cho riêng GPU, và khoảng ~4.6–7 tỷ đồng/tháng nếu tính thêm hệ thống làm mát (cooling, UPS, networking).

VinAI

Có khoảng 300–500 GPU A100/H100 (ước tính).

Chuyên R&D mô hình thị giác (autonomous vehicle, healthcare).

Mức tiêu thụ điện vài trăm kW, tương đương một tầng Data Center nhỏ. Tiêu thụ khoảng 0.3 MW, tương đương ~0.8 tỷ đồng/tháng, hoặc ~1.2–1.5 tỷ đồng/tháng khi tính thêm chi phí hạ tầng phụ trợ.

Zalo AI

Chủ yếu inference và LLM phục vụ Zalo/Zing News, không training nặng.

Dùng GPU tầm A6000 – A100, quy mô vài trăm card. Công suất khoảng 0.2 MW, ước ~0.5 tỷ đồng/tháng, hoặc ~0.8–1.1 tỷ đồng/tháng nếu tính đủ cooling và vận hành liên tục.

Tổng hợp ba đơn vị trên, chi phí điện riêng cho ngành AI tại Việt Nam có thể lên tới khoảng 80 tỷ đồng mỗi năm, ngay cả khi chỉ hoạt động 16 tiếng mỗi ngày.

Nếu các hệ thống này mở rộng quy mô thêm vài nghìn GPU hoặc chuyển sang vận hành 24/7, con số này có thể tăng gấp rưỡi.

Mở Rộng Ra Thế Giới

BloombergGPT, JP Morgan AI Labs, Shell AI, Siemens Industrial AI, Tesla Autopilot. Các cụm này thường chỉ cần vài chục nghìn GPU (10–50 MW), tức nhỏ hơn nhiều so với hạ tầng LLM toàn cầu.

AI Quốc Gia Hậu Thuẫn

Saudi Aramco / KAUST AI Cloud (Ả Rập Saudi): 0.3 GW → 1 GW planned.

Huawei Cloud / Baidu ERNIE / Alibaba Qwen (Trung Quốc): tổng cộng ~1.5 GW.

EU “EuroHPC” + CERN AI Center: ~0.5 GW khi hoàn thiện.

Các cty huấn luyện LLM – Large Foundation Model toàn cầu

- Anthropic: Claude 3.x → 4 tiêu thụ ~1 GW (NVIDIA H100)

- Google: DeepMind / Gemini Gemini 2 / Gemini Ultra tiêu thụ ~2 GW (TPU v6)

- xAI (Grok): Model XAI-1 & successor tiêu thụ 0.5–1 GW (H100)

- Meta: LLaMA 3 / 4 tiêu thụ 1.5–2 GW (A100 → H100)

- Amazon / Bedrock / Alexa LLM: multi-model training infra tiêu thụ ~1 GW

Ở Trung Quốc:

Baidu: ERNIE Bot, “Kunlun” + “ERNIE Compute Cluster” tại Bắc Kinh & Quảng Châu. ROI của công suất, đang tiêu thụ gần 1 nữa công suất điện của OpenAI hiện nay nhưng hiệu suất kém hơn vì giới hạn phần cứng phần mềm và cấm vận. So với cái deal mới của OpenAI thì khoản 8% qui mô.

DeepSeek

Deepseek là ngôi sao hiện nay với tuyên bố sử dụng chi phí vô cùng rẻ, là ngựa ô của Trung Quốc. Mô hình đạt gần GPT-4, chi phí huấn luyện cực thấp, sủ dụng toàn GPU trong nước. Sử dụng chip ~28,000 Ascend 910B (Huawei), toàn cụm chỉ tiêu thụ ≈ 10–12 MW = 0.01 GW. HIệu năng tổng chỉ tốn 1/50 so với của OpenAI Gpt4 cluster. Tức chỉ cần điện một tòa nhà văn phòng là Deepseek đã nổi bật gần với GPT-4.

Alibaba (Qwen / Tongyi)

~300k GPU (H800/H20)

~0.25 GW

Huawei Cloud (Pangu, Ascend 910C)

~400k chip

~0.3 GW

Tencent Hunyuan AI

~250k GPU

~0.2 GW

ByteDance (Doubao AI)

~200k GPU

~0.15 GW

- OpenAI: như “nhà máy điện hạt nhân cho AI”, 6 GW, mạnh nhất thế giới.

- Baidu: như “thủy điện lớn”, ~0.5 GW, lớn nhất Trung Quốc.

- Alibaba / Huawei / Tencent: “điện khu công nghiệp”, 0.2–0.3 GW mỗi cụm.

- DeepSeek: “trạm phát năng lượng di động”, 0.01 GW, siêu tiết kiệm nhờ tối ưu thuật toán.

- FPT / VinAI: “phòng lab hiện đại”, 0.001 GW, quy mô R&D khu vực.

Vì Sao Không Dùng DeepSeek Có Năng Suất Cao Cùng Mức Tiêu Thụ Điện Năng Thấp

Chung qui cũng như tiêu chuẩn thông thường là mặc dù mã nguồn mở, công bố paper nhưng AI này chỉ chạy tiếng Trung Quốc giỏi, còn tiếng Anh thì xịt đụi nên về mặt hiệu suất gần tới tương đương Gtp4 là nói về tiếng Trung Quốc mà thôi.

Về mặt sử dụng chip thì cũng dùng riêng chip nội địa nên việc triển khai phần cứng là gần như không thể đối với toàn cầu.

Sử dụng rào cản luật pháp nội bộ của Trung Quốc, tức là prompt sẽ bị giới hạn theo luật định của chính phủ Trung Quốc.

Khi tải bộ source này về mặc dù tuyên bố là mã nguồn mở nhưng khi tải thì phải cung cấp chứng minh nhân dân thực hoặc ICP number

Hoàn toàn ko support GPU AMD hay Nvidia. Sử dụng trên Hugging Faces cũng không đồng bộ theo tiêu chuẩn đã định. Không có backend chuẩn, cả thế giới dùng PyTorch, Deepseek chạy riêng Huawei Ascend + MindSpore framework

Việc này nói chung cũng liên quan an ninh riêng mà chính phủ Trung Quốc đề ra nên miễn ý kiến, xài được thì xài không được thì thôi ông không quan tâm.